·

16/02/2026

REINO UNIDO: dificultades para basarse en nuevos indicadores y métricas no tradicionales

Publicado en THE Times Higher Educationhttps://www.timeshighereducation.com/news/inconsistency-fears-after-ref-retreat-environment-metricsTemor a la «inconsistencia» tras el retroceso del REF en materia de métricas medioambientalesSegún los expertos, se necesita una orientación clara sobre cómo se calificarán las presentaciones basadas en narrativas para evitar acusaciones de que los juicios son excesivamente subjetivos. Publicado el 5 de enero de 2026.Jack Grove.Twitter: @jgro_theEl uso limitado de métricas en la sección medioambiental renovada del Marco de Excelencia Investigadora (REF) del Reino Unido ha suscitado inquietudes sobre cómo se evaluará de manera coherente.Se teme que la sección recientemente renombrada como «estrategia, personas y entorno de investigación» (SPRE) sufra las mismas críticas que su predecesora, «personas, cultura y entorno» (PCE), que algunos consideraban poco sólida, dado que las instituciones eran calificadas en función de extensas presentaciones narrativas. Se esperaba que un programa piloto que examinara posibles «indicadores» en áreas como la formación del personal, el acceso abierto y la diversidad pudiera generar métricas que permitieran una evaluación simplificada y objetiva.Sin embargo, un informe sobre el programa piloto publicado el mes pasado reveló que la recopilación de datos resultó difícil para los participantes. Algunos datos, como los recopilados para el Marco de Intercambio de Conocimientos exclusivo de Inglaterra, no estaban disponibles para todas las instituciones, mientras que la recopilación de datos para otras métricas habría supuesto una «carga significativa» para las instituciones y sería «imposible de recopilar de forma retrospectiva», según se constató.Además, la población relevante para muchos de los indicadores de investigación era «poco clara» y «podría no ser adecuada para todas las disciplinas», lo que significa que «no se podían aplicar de manera uniforme en todo el ejercicio».El informe, que recomendaba un «marco mucho más estricto para un ejercicio REF a gran escala», solo proponía un puñado de métricas para la sección PCE sobre las que existía un «acuerdo razonable» entre los miembros del panel que evaluaron las propuestas del programa piloto. Entre ellas se incluyen: datos longitudinales sobre el personal investigador basados en el sexo, el origen étnico y la discapacidad; diferencias salariales para cada una de estas características protegidas; cifras de investigadores noveles recién contratados, personal de apoyo técnico y personal con contratos de duración determinada. El informe añade que también se podrían incluir datos sobre el número de veces que se accede a los conjuntos de datos compartidos o la proporción de resultados de investigación publicados en acceso abierto.Si se vuelve a pedir a los paneles del REF que examinen declaraciones narrativas respaldadas solo por unos pocos datos, habrá que reflexionar más sobre cómo evitar la acusación de que las evaluaciones puedan considerarse «demasiado subjetivas», afirma Simon Green, vicerrector (investigación e intercambio de conocimientos) de la Universidad de Salford y miembro del panel para el proyecto piloto destinado a examinar los indicadores a nivel institucional.«La coherencia en la evaluación es fundamental. Con algo tan amplio como el SPRE, es normal que los miembros del panel den diferente importancia a los distintos elementos dentro de cada sección», afirmó, añadiendo que los paneles tendrán que desarrollar métodos de trabajo para mitigar esto.Green señaló que, aunque los organizadores del REF han aclarado que el contexto, en contraposición al rendimiento absoluto, será importante en la evaluación de las declaraciones a nivel institucional, «sería útil que esto se extendiera a las declaraciones a nivel de unidad, para evitar el riesgo de una evaluación inconsistente».Afirmó que, en su opinión, existía «un reconocimiento cada vez mayor de que evaluar el SPRE requiere conocimientos especializados», lo cual «difiere de evaluar los resultados y el impacto».Esto podría significar que los miembros del panel necesitan una formación específica, sugirió, o que los organizadores deben plantearse «si los mismos miembros del panel deben evaluar los tres elementos». John Womersley, antiguo presidente ejecutivo del Consejo de Instalaciones Científicas y Tecnológicas, afirmó que el abandono del uso generalizado de métricas en la PCE podría reflejar la constatación de que este enfoque favorecería la «jerarquía arraigada» de las universidades intensivas en investigación. Según el informe piloto, las universidades más grandes tenían muchas más probabilidades de obtener una calificación de 4* en cuanto al entorno de investigación, según los datos recopilados.«Las narrativas parecen más igualitarias», afirmó Womersley, y añadió que «los cínicos podrían señalar que quienes promueven lo que podría denominarse una agenda de «justicia social» siempre han tratado de alejar las evaluaciones de las métricas puras, como el recuento de publicaciones en revistas de gran impacto, etc.».Una de las recomendaciones más importantes de los paneles piloto es que las declaraciones medioambientales deben contener una «autorreflexión» y centrarse en la «mejora continua» para que se consideren 4*.Para Green, este elemento es crucial. «Un aspecto en el que la claridad será especialmente importante es que las declaraciones SPRE, tanto a nivel institucional como de unidad, deben basarse en una autoevaluación honesta, y no limitarse a presentar una imagen muy pulida y selectiva de la propuesta en cuestión».****************************************‘Inconsistency’ fears after REF retreat on environment metricsClear guidance needed on how narrative-based submissions will be graded to avoid accusations that judgements are overly subjective, say experts Published on January 5, 2026Last updated January 5, 2026Jack GroveTwitter: @jgro_theLimited use of metrics in the UK’s Research Excellence Framework (REF)’s revamped environment section has raised concerns about how it will be consistently evaluated.There are fears the newly renamed “strategy, people and research environment” (SPRE) section will suffer from the same criticisms of its predecessor, “people, culture and environment” (PCE), which some felt lacked robustness, given institutions were graded on lengthy narrative-based submissions. It was hoped a pilot examining potential “indicators” covering areas such as staff training, open access and diversity might produce metrics to allow a streamlined and objective assessment.But a report on the pilot published last month found data collection proved difficult for those participating. Some data – such as that collected for the England-only Knowledge Exchange Framework – was not available for all institutions, while collecting data for other metrics would have imposed a “significant burden” on institutions and would be “impossible to collect retrospectively”, it found. In addition, the relevant population for many of the research indicators was “unclear” and “might not be appropriate for all disciplines”, meaning they could “not be applied evenly across the entire exercise”.Recommending a “much tighter framework for a full-scale REF exercise”, the report put forward only a handful of metrics for the PCE section on which there was “reasonable agreement” among panellists who assessed the pilot’s submissions. These include: longitudinal data on research staff based on sex, ethnicity and disability; pay gaps for each of these protected characteristics; numbers for newly employed early career researchers, technical support staff and staff on fixed term contracts. Data on how many times shared datasets are accessed or the share of research outputs published open access could also be included, adds the report.If REF panels will again be asked to examine narrative statements supported by only a handful of data points, more thought will need to be given to how to avoid the charge that assessments might be seen “overly subjective”, said Simon Green, pro vice-chancellor (research and knowledge exchange) at the University of Salford, a panel member for the pilot’s effort to examine institutional level indicators. “Consistency of evaluation is key. With something as broad as SPRE, it is normal that panel members will place different emphasis on the different elements within each section,” he said, adding that panels will need to develop working methods to mitigate this.Green said that while REF organisers had clarified that context, as opposed to absolute performance, will matter in the assessment of institution-level statements, “it would be helpful to see this extended to unit-level statements, to avoid the risk of inconsistent assessment”. He said he felt there was “a growing recognition that assessing SPRE requires specialist understanding” that was “different to evaluating outputs and impact”.This might mean that specific training is needed for panel members, he suggested, or organisers may need to question “whether the same panel members should be assessing all three elements”. John Womersley, former executive chair of the Science and Technology Facilities Council, said the shift away from the greater use of metrics in PCE could have reflected the realisation that this approach would favour the “entrenched hierarchy” of research-intensive universities. According to the pilot report, larger universities were far more likely to be judged 4* for research environment based on the data collected.“Narratives feel more egalitarian”, said Womersley, adding that “the cynic might note that those pushing what one might call a ‘social justice’ agenda have always tried to steer assessments away from pure metrics, like counting publications in high-impact journals and so on”. One of the strongest recommendations of the pilot’s panels is that environment statements should contain “self-reflection” and a focus on “continuous improvement” if they are to be deemed 4*.For Green, this element is crucial. “One aspect on which clarity will be particularly important is that SPRE statements, both at institutional and unit levels, should be based on honest self-assessment, and not just present a highly-polished and selective picture of the submission in question.”jack.grove@timeshighereducation.com*********************************

11/02/2026

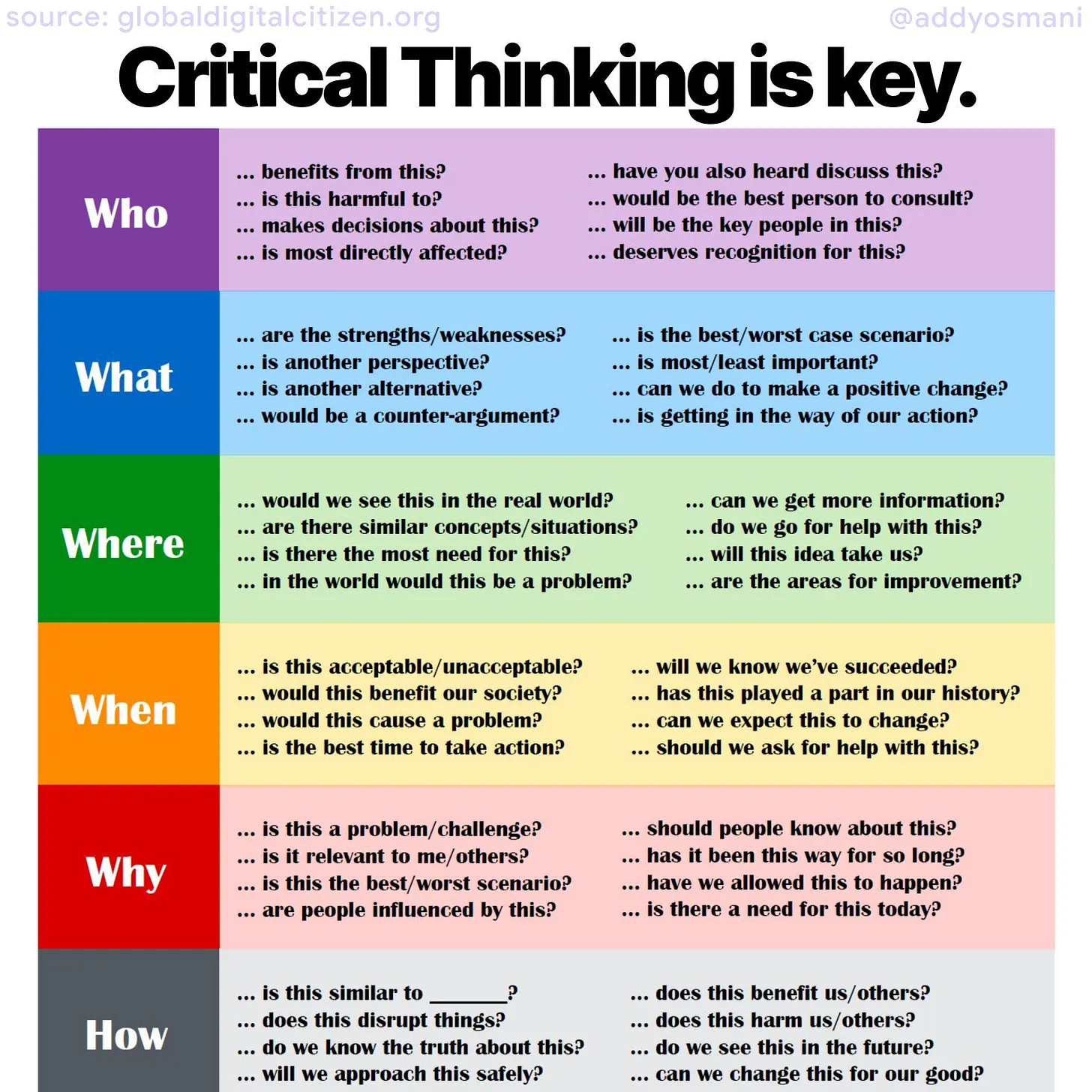

Pensamiento crítico en la era de la IA: quién, qué, dónde, cuándo, por qué, cómo

Addy Osmani. Critical Thinking during the age of AI. Publicado el 21 de noviembre de 2025 en Substack (Addyo). Texto completo El artículo destaca que, en una época en la que la inteligencia artificial puede generar código, ideas de diseño y respuestas plausibles de inmediato, el pensamiento crítico humano es más esencial que nunca. Osmani…

26/01/2026

Adiós a Elsevier y Clarivate: OpenAlex y la nueva era de la ciencia abierta

Winemiller, Sam. 2026. “OpenAlex and Values‑Aligned Tools.” ACRLog, 26 de enero de 2026. https://acrlog.org/2026/01/26/openalex-and-values-aligned-tools/ Se hace una llamada a la comunidad académica y bibliotecaria para cuestionar la hegemonía de herramientas comerciales en la evaluación científica y abrazar alternativas abiertas como OpenAlex —no solo por su utilidad técnica, sino también por su potencial para reflejar y…

21/01/2026

Miles de citas invisibles se infiltran en artículos y generan métricas falsas

Joelving, Frederik. “How Thousands of Invisible Citations Sneak into Papers and Make for Fake Metrics.” Retraction Watch, 9 de octubre de 2023. https://retractionwatch.com/2023/10/09/how-thousands-of-invisible-citations-sneak-into-papers-and-make-for-fake-metrics/ El artículo de Retraction Watch expone un fenómeno descubierto en 2022 por el científico informático Guillaume Cabanac: ciertos trabajos científicos acumulaban un número inusualmente alto de citas en poco tiempo a pesar…

26/12/2025

Una nueva prueba de IA analiza si los chatbots protegen el bienestar humano

Bellan, Rebecca. “A New AI Benchmark Tests Whether Chatbots Protect Human Well-Being.” TechCrunch, November 24, 2025. https://techcrunch.com/2025/11/24/a-new-ai-benchmark-tests-whether-chatbots-protect-human-wellbeing Se describe la creación de un nuevo benchmark llamado HumaneBench diseñado para evaluar si los chatbots de inteligencia artificial realmente protegen el bienestar humano en lugar de simplemente maximizar la interacción o el compromiso del usuario. A diferencia…

10/12/2025

Citas invisibles y métricas falsas: la ingeniería oculta detrás de las métricas científicas

“How Thousands of Invisible Citations Sneak into Papers and Make for Fake Metrics.” Retraction Watch. Publicado el 9 de octubre de 2023.https://retractionwatch.com/2023/10/09/how-thousands-of-invisible-citations-sneak-into-papers-and-make-for-fake-metrics/ Se describe cómo investigadores detectaron un mecanismo de manipulación de métricas científicas consistente en la inserción de «citas invisibles» (o “sneaked citations”). En 2022, el informático Guillaume Cabanac observó un caso extraño: un…

No hay más contenido disponible